by Blog AEC GOVERTIS

|Jul 2, 2025

|

0 Comments

|

DPD DPO

El pasado miércoles, 25 de junio, tuvo lugar la celebración del II Insight del Club del DPD de este año 2025, como siempre organizado por la Asociación Española para la Calidad, con la colaboración de Govertis, part of Telefónica Tech.

En esta edición del evento, contamos con la dirección de Javier Villegas, Lead Advisor de Data Protection Officers en Govertis, part of Telefónica Tech, estructurando la presentación en tres partes:

- La petición de copias de DNI y su relación con el ámbito de la protección de datos.

- El análisis del Plan Estratégico de la AEPD.

- El taller exclusivo para miembros del Club DPD en materia de herramientas de IA para el ejercicio de las funciones de DPD.

- Petición de copias del DNI y protección de datos: ¿cuándo, cómo y por qué?

Esta primera ponencia ha sido ofrecida por María Jiménez, Delegada de Protección de Datos y Legal Advisor en Govertis, part of Telefónica Tech.

María se adentró en una materia que genera actualmente mucha controversia, ya que no siempre está claro si es posible obtener copias del DNI de los ciudadanos y, si lo fuese, de qué modo y bajo qué pretextos sería lícita esta práctica.

La primera labor comenzó contextualizando el marco normativo en el que se articula esta materia: la Constitución Española, la Carta de los derechos fundamentales de la Unión Europea, el RGPD, nuestra LOPD-GDD y el resto de normativas sectoriales y autonómicas aplicables, que son de especial atención en el ámbito del DNI.

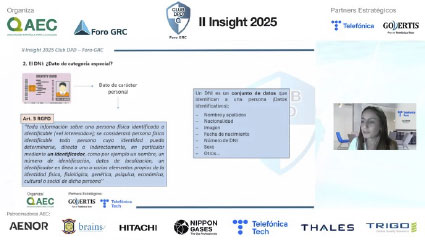

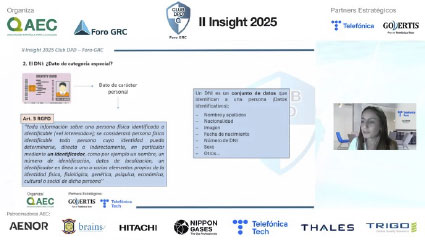

Seguidamente, María destacó la naturaleza del DNI, entendible como un dato de carácter personal, pero con una especial atención al hecho de que se presenta como un «paquete de datos» que abarca el nombre, apellidos, nacionalidad, imagen, número identificativo y demás categorías.

Sin embargo, ningún dato obrante en el DNI se presenta como un dato de categoría especial (artículo 9.1 RGPD) en sentido estricto, pero por su especialidad, por ser el contenedor de diversa información es precisamente la razón por la que nos encontramos con un dato de una sensibilidad particular, en la medida en que es un dato único, permanente y ampliamente aceptado para autenticar inequívocamente a una persona, con todos los riesgos de suplantación y acciones derivadas que ello supone.

Asentado lo anterior, cabe determinar cuándo se puede solicitar el DNI. Esto es, qué base de licitud va a resultar aplicable al tratamiento del DNI.

Es la propia AEPD la que establece una regla básica para tratar el DNI: que exista una norma que así lo establezca y que ello derive de una necesidad demostrable.

Sobre ello podemos mencionar varios ejemplos en los que se podrá tratar el DNI:

- Cuando un vigilante de seguridad lo requiera para controlar el acceso a instalaciones

- Cuando lo solicite cualquier persona elegida para formar parte de una mesa electoral a todo aquel que acuda a votar

- Cuando nos lo requieran en establecimientos o servicios que tengan que ver con actividades relevantes para la seguridad ciudadana y locales de juego

- Cuando lo requiera justificadamente la Autoridad o sus Agentes

Lo siguiente que se debe abordar es cómo solicitar el DNI, respondiendo a la cuestión sobre si escanear o fotografiar el DNI es siempre lícito.

En este sentido, el criterio de la AEPD es claro: la copia del DNI debe evitarse siempre que existan alternativas menos intrusivas, y no exista una ley que nos obligue a conservarlo.

Entre los ámbitos de actuación más afectados por esta problemática podemos encontrar:

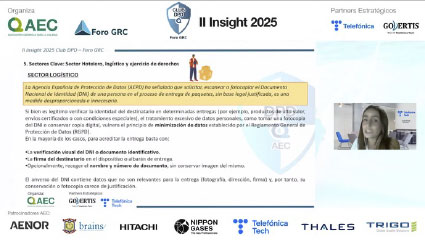

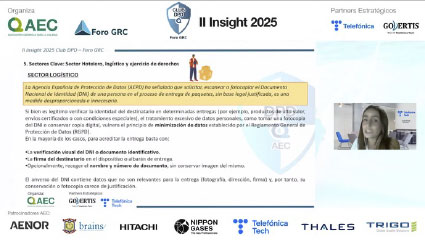

- El sector hotelero, en el que la AEPD ha hecho hincapié expreso (y en la que se continúan emitiendo sanciones por su parte) en que no es legal solicitar el DNI para tomarle fotografías, escaneos o copias. Sí lo será tomar datos que constan en el DNI, pero únicamente los mínimos y necesarios para la finalidad que se persigue en el check-in.

- El sector logístico: la AEPD igualmente se ha pronunciado indicando que solicitar, escanear o fotocopiar el DNI por parte de un repartidor de paquetería, sin base legal justificado, es una medida desproporcionada e innecesaria.

Esta práctica debería sustituirse por otras alternativas menos lesivas, tales como la verificación visual del DNI, la firma del destinatario en el dispositivo o albarán de entra u, opcionalmente, recoger únicamente el nombre y número de DNI del destinatario del paquete.

- El ámbito del ejercicio de derechos por parte de los afectados por los tratamientos de datos: en el caso de que la entidad a la que se dirige el afectado tenga dudas sobre la identidad del ejercitante, debe recurrir a métodos de identificación igualmente alternativos sin caer en la petición de copias del DNI.

Esto conlleva entender que el foco principal que se debe tener en cuenta es la atención al principio de minimización: únicamente deberá recogerse el dato o datos personales que sean mínimos, proporcionales y estrictamente necesarios para la finalidad específica (y legítima) que se persigue.

Cabe igualmente no perder de vista la necesidad de integrar garantías y medidas de seguridad adecuadas en los intercambios de este tipo de información, dada la especial sensibilidad del DNI como conjunto. Entre ellas, María destacó el contar con portales web con autenticación robusta (2FA), correos electrónicos cifrados, controles de acceso, comunicaciones cifradas de extremo a extremo y herramientas de firma electrónica reconocida, entre otros.

Llegando a la última cuestión, cabe hablar del por qué: ¿por qué es necesaria la especial protección del DNI?

La respuesta pasa inevitablemente por los riesgos que existen sobre un mal uso de esta información: la posible suplantación de identidad, el tratamiento no autorizado, la pérdida del control de los datos y, en los peores escenarios, fraudes financieros, estafas o revelación de secretos.

Todo ello nos lleva a varias conclusiones:

- El DNI adquiere un carácter sensible por su carácter de identificación inequívoca e indubitada y los riesgos sobre los derechos y libertades de los interesados.

- Solo se acepta la solicitud del DNI cuando exista un imperativo legal.

- Que existen sectores más críticos que sí obligan a solicitar el DNI, pero no el escaneo ni la fotografía.

- Que además de tener una base de legitimación para su tratamiento, es necesario realizar un equilibrio entre el tratamiento del dato y los principios de minimización, finalidad, proporcionalidad, limitación, pertinencia y conservación.

- Que se debe contar con un enfoque por defecto sobre los riesgos asociados al tratamiento.

- ¿Quo Vadis RGPD? Análisis del Plan Estratégico de la AEPD por los divulgadores en protección de datos.

Este segundo bloque de contenidos, en forma de mesa de debate, estuvo moderado por Coral Pelegrín, DPD-GRC Senior Consultant en Govertis, quien ha estado acompañada de algunos de los divulgadores más influyentes del país:

- María Luisa González Tapia, counsel en Ramón y Cajal Abogados.

- Daniel Fernández-Viagas, responsable de GRC interno en SIRT.

- Jorge Campanillas, socio abogado en Iurismática Abogados.

En esta mesa de debate se abordó el contenido del del Plan Estratégico de la Agencia Española de Protección de Datos (AEPD) 2025-2030, cuyo enfoque pasa por el momento de transformación digital que atraviesa la sociedad.

Dentro de este Plan, la AEPD propone ocho principios rectores de actividades, estableciendo a continuación seis grandes ejes de actuación para conseguirlos.

Los principios rectores contenidos en el Plan son los siguientes:

- Innovación y adaptabilidad.

- Internacionalización e influencia.

- Cooperación.

- Proactividad y prevención.

- Excelencia y calidad técnica.

- Defensa del interés general.

- Agencia abierta.

Por su parte, los grandes ejes de actuación propuestos son:

Eje 1. Supervisión inteligente.

Eje 2. Innovación tecnológica.

Eje 3. Cooperación e influencia estratégica.

Eje 4. Facilitar el cumplimiento normativo.

Eje 5. Transformación digital y excelencia.

Eje 6. Una Agencia abierta y cercana.

María Luisa González, desde una perspectiva más apegada al ámbito de la abogacía, seleccionó el eje de actuación de supervisión inteligente (implementar sistemas avanzados para detección de riesgos y optimizar procesos internos utilizando IA), facilitar el cumplimiento normativo, ayudar en el cumplimiento a las Pymes y el eje de PROPONER una AEPD más abierta y cercana, en escucha permanente con los diversos sectores sociales.

Sobre ello, María destacó la actividad de la ICO, la Autoridad competente en materia de protección de datos británica, que siempre ha estado en contacto con los sectores afectados por los tratamientos y demás ámbitos sociales.

También puso en valor la necesidad de aumentar recursos en la AEPD, que la deje de convertir en una «agencia de consumo dentro del ámbito de la protección de datos» y sirva de un organismo verdaderamente útil y necesario para los sectores afectados.

Daniel Fernández-Viagas, por su parte, destacó el eje de la cooperación con otras Autoridades y el refuerzo del cumplimiento normativo.

El mensaje central para él, en este sentido, es que «para un DPD, es básico tener contrastada con varias Autoridades de Control las diferentes cuestiones que puedan ser de afectación».

Se reafirma en las ideas expuestas por sus compañeros Jorge Campanillas, que hizo mayor hincapié en la elaboración de un laboratorio de desarrollo e innovación digital, sandbox, que tienda a abrazar el uso de la tecnología en pos del cumplimiento normativo. No siempre hay que demonizar el uso de la IA, también puede ayudarnos en nuestro trabajo y a la sociedad.

El mensaje final fue, igualmente, reafirmar la necesidad de cooperación entre las diferentes Autoridades, aunando criterios y ejerciendo una labor de guía que estaba más perdida en los días actuales.

Es clave que «los ciudadanos comprendan para qué estamos los Delegados de Protección de Datos».

En otro orden de cuestiones, abordando cuestiones sobre metodología y riesgo, María Luisa hizo hincapié en la necesidad de reforzar y consolidar una metodología válida sobre el análisis de riesgos, los procesos de anonimización y las evaluaciones de impacto que no se presenten únicamente como un setlist sino como una metodología material y homogénea.

Daniel suscribió el planteamiento anterior poniendo el foco en la metodología del análisis de riesgos: «no puede ser que el foco central sea únicamente el negocio y no el usuario o los derechos respectivos».

También aprovechó la ocasión para destacar que el criterio sobre el uso de la biometría tiene margen de mejora, debiendo flexibilizar el uso de la misma para determinados escenarios que en la práctica son muy razonables.

Jorge, en la misma línea, sostuvo que lo que se está trasladando a la ciudadanía con el actual criterio sobre el uso de la biometría convierte algunas prácticas habituales, como abrirse una cuenta bancaria con un escaneo facial, en cuestiones difíciles de encajar con otros supuestos de uso ilícito de este tipo de tecnología.

Por otro lado, no pasó desapercibido el cuarto eje del Plan de la AEPD, en el que se integra la voluntad de potenciar y reforzar la figura del Delegado de Protección de Datos.

Para Daniel, es fundamental que el DPD no se presente como una figura muy saturada de trabajo o que su conocimiento tenga que abarcar todos los ámbitos. Para él, la clave está en rodearse de equipos multidisciplinares que sepan asesorar y mantener una posición activa dentro de las empresas, codeándose con todos los departamentos para empaparse de la realidad de la problemática que le rodea.

En cualquier caso, el principal hándicap a resolver en muchas organizaciones, incluyendo la Administración Pública, es dotar de recursos a esta figura, así como no denostar su trabajo forzando la necesidad de que sean unos «superhéroes» del conocimiento.

Por último, en este bloque, se comentaron los desafíos a futuro en protección de datos, que todos los intervinientes coinciden en que van alineados con los principales ejes de actuación de la AEPD, en los que se debe acompañar con «formación, formación y formación» para los que ejercen las labores de DPD, sobre todo en área de ciberseguridad, tal como concluye Daniel.

- Taller exclusivo para miembros del Club: herramientas de IA para el ejercicio de las funciones de DPD.

La jornada cerró con un taller práctico exclusivo para miembros del Club del DPD, dirigido por un invitado muy especial: Alejandro Sánchez del Campo Redonet (Replicante Legal), abogado experto en derecho digital y referente en el ámbito LegalTech.

Alejandro comenzó su ponencia aclarando que su contenido no solo versaría sobre las herramientas basadas en inteligencia artificial, sino en el propio impacto que la IA tiene (y tendrá) en las labores de los DPD.

Y este enfoque le llevó a plantear un titular inicial que lleva reflejando los últimos tiempos del sector: «solo un tercio de los letrados tiene suficiente formación en tecnología».

Sin perjuicio de que se trata de una realidad que afecta principalmente al ámbito legal externo a la esfera de actuación de los Delegados de Protección de Datos, la falta de conocimiento suficiente en áreas tecnológicas, sobre todo ligadas a la Inteligencia Artificial, hace que sea necesario reforzar la formación en estas competencias.

Esta problemática invita a reflexionar, en opinión del ponente, sobre si la existencia de herramientas de IA, sobre todo el ChatGPT, supone una evolución para la sociedad o una revolución.

Alejandro exploró el concepto de ChatGPT aclarando que se trata de un modelo de lenguaje, no de una base de datos entrenada para aspectos legales o tecnológicos puramente.

Otro titular que ha dejado abierto al debate el ponente expuso los posibles límites, si los hubiese, de este tipo de herramientas de IA generativa. Es decir, se trata de responder a la pregunta de si habrá alguna de las tareas que realiza un DPD o un profesional asociado al mundo de la privacidad o el Derecho que no pueda realizar la IA.

Sobre todo, teniendo en cuenta que cada vez son más los grandes despachos y asesorías jurídicas los que tejen alianzas con plataformas como Legora o Harvey para optimizar sus funciones, estructura y dotar de mayor eficiencia a sus labores de asesoramiento.

Dentro del área de consultoría GRC y compliance en materia de protección de datos, Alejandro destacó otras herramientas como Complylaw o Gobercom 360, ambas tendentes a facilitar y optimizar los trabajos de consultoría en esta materia. Sin embargo, en estos dos ejemplos, hay una gran presencia de IA (al menos en comparación con el sector puramente legal).

Más adelante, Alejandro introdujo el horizonte que se está dibujando dentro del universo de la IA, convirtiendo las herramientas y procesos de automatización exclusiva en modelos de agente IA, en los que le puedes pedir que realice labores más complejas, con mayores comandos y acciones combinadas y que están dirigidas a dar con la tecla definitiva para optimizar nuestras profesiones, ya sean como Delegados de Protección de Datos, abogados o cualquier otro sector de aplicación.

«Al DPD le va a tocar entender la problemática legal, regulatoria y ética que plantea la IA. Como al abogado, pero para su campo. Muchos DPDs van a evolucionar a ser quienes se ocupen de la adecuación y compliance relacionado con el Reglamento de Inteligencia Artificial».

Esta aseveración arroja una pregunta que ya se planteaba al inicio de la ponencia, y es que teniendo en cuenta que muchas las labores del DPD pasan por un proceso, ¿cuánto de ese proceso se puede automatizar o «agentizar» a través de la IA?

En opinión de Alejandro, en un futuro no muy lejano, la labor del DPD y del abogado en general pasará por integrar la IA irremediablemente en su día a día. «Si se han podido automatizar los taxis en una ciudad como San Francisco, ¿por qué no se va a poder automatizar la labor del DPD?».

En cualquier caso, convendría hacer una lectura optimista de este reto que se plantea, aceptándolo como una realidad que conduce a una oportunidad futura, más que una amenaza para nuestra profesión.

Alejandro cerró su ponencia animando a formarse en detalle sobre la IA, el uso que se le podría dar comprendiendo su funcionamiento, ayudando a su mejora y así adelantarnos a la amenaza, liderando el futuro y aceptando la realidad que, en su opinión, es irrefrenable.

José Alejandro Veiga

Govertis, parte de Telefónica Tech

915 752 750

915 752 750