915 752 750

915 752 750

aec@aec.es

aec@aec.es

915 752 750

915 752 750

aec@aec.es

aec@aec.es

El pasado 26 de febrero, Madrid fue testigo de un evento clave para el ecosistema de la privacidad, la ciberseguridad y la inteligencia artificial con la celebración del I Congreso Foro GRC, organizado por la Asociación Española para la Calidad (AEC) en colaboración con Telefónica Tech y Govertis, part of Telefónica Tech.

El pasado 26 de febrero, Madrid fue testigo de un evento clave para el ecosistema de la privacidad, la ciberseguridad y la inteligencia artificial con la celebración del I Congreso Foro GRC, organizado por la Asociación Española para la Calidad (AEC) en colaboración con Telefónica Tech y Govertis, part of Telefónica Tech.

Más de mil personas inscritas, tanto presenciales como virtuales, se dieron cita en la emblemática Fundación Telefónica en un foro que abordó los desafíos y oportunidades actuales para profesionales del GRC (Gobierno, Riesgo y Cumplimiento).

El acto de apertura corrió a cargo de María Jesús Almazor, COO España, Hispam, Brasil y USA de Telefónica Tech, quien enfatizó el papel de la innovación en la transformación digital y la creciente preocupación por la ciberseguridad en todas las organizaciones: «El 70% de los ciberataques afectan a pymes. No podemos permitirnos seguir viéndolo como un problema ajeno».

A continuación, Avelino Brito, director general de la AEC, abordó la evolución de la calidad hacia la gestión integral de riesgos, destacando la relevancia de este foro para el futuro del sector.

Alberto González (Director de Operaciones, TI y Gestor del Club DPD y Club CISO de la AEC), junto con Eduard Chaveli (Head of Consulting Strategy de Govertis) y Óscar Bou (Head of Consulting Business de Govertis), fueron los encargados de conducir el evento y presentar el Foro GRC como una evolución natural de los anteriores clubes (CISO, DPD y Comunidad IA) hasta convertirse en un espacio de referencia para la intersección entre privacidad, ciberseguridad e IA.

«Este foro nace para ayudar a las organizaciones a entender y afrontar los desafíos del futuro», destacó Chaveli dando paso a la primera de las mesas redondas del Congreso.

Javier Villegas Flores (IT Lawyer, Associate – Lead Advisor DPDs en Govertis) fue el encargado de moderar y arrancar la primera mesa que abordó los retos normativos en el ámbito GRC con la participación de:

Javier Villegas Flores (IT Lawyer, Associate – Lead Advisor DPDs en Govertis) fue el encargado de moderar y arrancar la primera mesa que abordó los retos normativos en el ámbito GRC con la participación de:

Candau insistió en la necesidad de adoptar un enfoque preventivo: «No hay transformación digital sin ciberseguridad. Debemos implementar medidas de seguridad de manera nativa en nuestros sistemas».

Por su parte, Alonso se centró en la importancia de la gestión de incidentes, resaltando que «es crucial que las empresas sepan cómo actuar ante un incidente y cómo recuperarse».

Calvo, por su parte, subrayó la necesidad de entender el espíritu de la norma más allá del mero cumplimiento, señalando que «la norma es una herramienta, pero debemos ir más allá y asumir una responsabilidad proactiva en la protección de datos y la gestión de riesgos». Añadió que «no se trata solo de evitar multas, sino de proteger a las personas».

En una sociedad donde la IA juega un papel cada vez más relevante en la selección y gestión del talento, esta mesa, moderada por Jordi Morera (Lead Advisor Compliance en Govertis), reunió para debatir sobre los desafíos en el ámbito laboral a:

En una sociedad donde la IA juega un papel cada vez más relevante en la selección y gestión del talento, esta mesa, moderada por Jordi Morera (Lead Advisor Compliance en Govertis), reunió para debatir sobre los desafíos en el ámbito laboral a:

Eva Román destacó que, aunque el 99% de las empresas del índice Fortune 500 utilizan IA en procesos de selección, solo el 23% confía en que sus organizaciones se adapten adecuadamente. «La IA es un facilitador, pero el talento sigue siendo la principal fuente de diferenciación. Debemos empoderar a las personas, no sustituirlas», afirmó resaltando la importancia de la transformación cultural en las organizaciones.

Por su parte, Beltrán advirtió sobre los riesgos de la neurotecnología y la psicometría. «Estamos exponiendo nuestro yo inconsciente, que representa el 95% de nuestra actividad cerebral. Esto plantea serios desafíos para la libertad y la responsabilidad individual», explicó refiriéndose a cómo las tecnologías pueden influir en nuestras decisiones sin que ni siquiera lo percibamos.

Finalmente, Elena Gil se centró en las garantías legales existentes, como el artículo 22 del RGPD, que regula las decisiones automatizadas. «Aunque tenemos herramientas legales, su aplicación es compleja. Necesitamos más transparencia y menos sesgos en los algoritmos», afirmó destacando la importancia de la intervención humana en los procesos automatizados.

La mesa subrayó la necesidad de transparencia, justicia algorítmica y marcos normativos claros para evitar sesgos y vigilancia excesiva.

Para debatir sobre el papel de los profesionales GRC en un entorno tecnológico en constante evolución, Sandra Ausell Roca (GRC Senior Consultant de Govertis) fue la encargada de moderar esta mesa que contó con la participación de:

Para debatir sobre el papel de los profesionales GRC en un entorno tecnológico en constante evolución, Sandra Ausell Roca (GRC Senior Consultant de Govertis) fue la encargada de moderar esta mesa que contó con la participación de:

Juan José Nombela inició el debate subrayando la creciente complejidad del ecosistema de ciberseguridad debido a la globalización y la evolución tecnológica. «El reto está en encontrar un equilibrio entre la gestión de riesgos y el cumplimiento normativo en un entorno cambiante y con una gran escasez de talento», señaló. Además, subrayó la necesidad de formación continua y el apoyo de la alta dirección para integrar la seguridad en la estrategia empresarial.

Ahondando en los retos actuales, Richard Benjamins destacó el impacto que la inteligencia artificial está teniendo en el sector. «Uno de los mayores desafíos para los profesionales de GRC es comprender cómo funciona la tecnología a un nivel básico. Sin este conocimiento, es muy difícil anticipar y mitigar riesgos», afirmó.

Eduvigis Ortiz, por su parte, abordó el desafío de la escasez de talento y la importancia de la diversidad en el sector: «El 31% de los profesionales de ciberseguridad en España son mujeres, frente al 25% a nivel global», y destacó que «aunque hemos avanzado, todavía queda mucho por hacer para atraer más talento femenino y joven a la industria». Atendiendo a esta situación y con el objetivo de mostrar el valor y propósito del sector, Ortiz destacó el papel que llevan desempeñando desde Women4Cyber impulsando programas de mentoring y concienciación.

Desde la perspectiva académica, Pedro López Sáez, puso el foco en la necesidad de alinear la formación con las demandas del mercado laboral. «El déficit de talento en Europa es alarmante: faltan más de 1.300.000 profesionales en ciberseguridad y GRC. Las universidades deben adaptar sus programas para cubrir esta brecha y ofrecer formación que combine conocimientos técnicos y regulatorios», explicó.

La mesa concluyó con un consenso claro: la necesidad de fomentar la formación, el trabajo interdisciplinar y la colaboración entre equipos.

Bajo la moderación de José Antonio Sánchez (Coordinador del Club del CISO y GRC Senior Consultant en Govertis), esta mesa abordó uno de los temas más críticos en la actualidad: la desinformación como un factor que puede influir en procesos democráticos y la manera en que la inteligencia artificial y la ciberseguridad pueden ser tanto una amenaza como una herramienta para combatirla. Este espacio contó con la participación de:

Nuestro compañero abrió el debate con una reflexión sobre la inteligencia artificial y su capacidad para influir en la opinión pública donde los ponentes analizaron cómo la desinformación se ha convertido en una herramienta estratégica en conflictos políticos y sociales, y la manera en que las redes sociales han amplificado su impacto.

Ante este escenario donde «la desinformación es una gran amenaza para la democracia», Sánchez inició la mesa planteando la necesidad de abordar este fenómeno desde la inteligencia artificial y la ciberseguridad.

David Ramírez, desde su experiencia en RTVE, comenzó destacando la diferencia entre noticias falsas y desinformación estructurada, señalando que los medios de comunicación tienen la responsabilidad de garantizar fuentes verificadas y mecanismos de contraste para generar información. En este sentido, alertó de que «cualquier persona puede generar información que es opinión muchas veces» y que «las herramientas profesionales existen, están a disposición de los medios de comunicación». Además, destacó la importancia de implementar herramientas tecnológicas de verificación, aunque recordó que el factor humano sigue siendo esencial para discernir entre contenido legítimo y manipulado dado que «cualquier persona puede emitir una opinión con mayor o menor seguimiento o mayor o menor credibilidad» en redes sociales.

Por su parte, Pedro Coll, experto en gestión de crisis, abordó la relación entre libertad de expresión y regulación en redes sociales. Reflexionó sobre si las grandes plataformas deben autorregularse o si los gobiernos deberían intervenir de manera más estricta.

Coll confirmó que se trata de un tema muy complejo y, en cuanto a la tecnología, insistió en la ética en el uso de la inteligencia artificial sugiriendo seguir un esquema basado en la Unesco. Preguntó: «¿Te importa si el resultado es verdadero? Si contestas no, utiliza ChatGPT. Si dices sí, el siguiente paso es: ¿Tú tienes conocimiento suficiente para verificar si el resultado es verdadero? Si la respuesta es no, entonces no utilices ChatGPT».

Hernández hizo hincapié también en la importancia de educar en el consumo crítico de la información: «Cuando tú hablas con los jóvenes y les dices cómo se informan, que es una pregunta que yo suelo hacer mucho cuando interactúo con ellos, pues se informan en Instagram y en TikTok». Y no solo ante el consumo de información, Hernández también destacó el papel de la educación en ciberseguridad en las organizaciones en relación al debate iniciado por Sánchez en el que alertaba de que los ciberatacantes también pueden alterar los datos de entrenamiento de los modelos de IA para manipular sus resultados.

Los ponentes coincidieron poniendo el foco en la responsabilidad de los medios de comunicación y las plataformas digitales. Explicaron que los algoritmos de recomendación y personalización están diseñados para mostrar contenido que refuerce los sesgos del usuario, lo que contribuye a la viralización de bulos.

Todos ellos concordaron en la necesidad de combinar educación, tecnología y regulación para minimizar el impacto de la desinformación y garantizar un uso responsable, ético y seguro de la IA.

Uno de los momentos más esperados del evento fue la entrega de premios de esta primera edición del Congreso Foro GRC, que quiso reconocer la labor de profesionales y entidades destacadas en este ámbito:

En su discurso, España dedicó unas palabras a sus sucesores, Lorenzo Cotino y Francisco Pérez Bes, nombrados recientemente como presidente y adjunto de la AEPD respectivamente: «Desde aquí, les deseo lo mejor en un momento clave, donde la IA está en pleno desarrollo y nos jugamos el modelo ético de sociedad: nuestra identidad personal, nuestra identidad digital y nuestro propio bienestar».

El evento contó también con ponencias como la de Javier Sirvent, quien reflexionó sobre el impacto de la inteligencia artificial en la sociedad. Con su característico estilo, Sirvent presentó las disrupciones tecnológicas que están moldeando el futuro y cómo la IA está transformando el mundo como lo conocemos.

El evento contó también con ponencias como la de Javier Sirvent, quien reflexionó sobre el impacto de la inteligencia artificial en la sociedad. Con su característico estilo, Sirvent presentó las disrupciones tecnológicas que están moldeando el futuro y cómo la IA está transformando el mundo como lo conocemos.

Sirvent utilizó ejemplos impactantes para ilustrar sus predicciones: «Estamos viviendo una disrupción evolutiva por culpa o gracias al COVID». Además, mencionó que «todas estas enfermedades serán tratables o curables en los próximos 10, 15 años» gracias a avances como el ARNm, que «se diseñó y se programó gracias a una IA». También habló del impacto en la productividad empresarial, advirtiendo que «las empresas que no integren IA en sus procesos quedarán obsoletas en un abrir y cerrar de ojos».

Cerró su intervención con un mensaje inspirador: «La IA no es el enemigo, el enemigo es la falta de adaptación. No tengamos miedo de la inteligencia artificial, sino de quedarnos atrás».

Concurso de ponencias

Este encuentro contó también con un espacio en donde se premiaron dos interesantes ponencias seleccionadas por el jurado del Congreso por su rigor académico, su enfoque innovador y su contribución al debate sobre el futuro de la tecnología y su impacto en la sociedad:

Jorge García Herrero, evangelista del RGPD y premio AEPD 2019, exploró con su particular tono de humor los desafíos y oportunidades de la coexistencia entre el Reglamento de Inteligencia Artificial (RIA) y el Reglamento General de Protección de Datos (RGPD) recordando ambos roles: «El RGPD es un reglamento de principios, no como el RIA, que es de seguridad de producto. El RGPD regula el tratamiento de datos que se produce dentro de la tecnología, funcione como funcione».

Jorge García Herrero, evangelista del RGPD y premio AEPD 2019, exploró con su particular tono de humor los desafíos y oportunidades de la coexistencia entre el Reglamento de Inteligencia Artificial (RIA) y el Reglamento General de Protección de Datos (RGPD) recordando ambos roles: «El RGPD es un reglamento de principios, no como el RIA, que es de seguridad de producto. El RGPD regula el tratamiento de datos que se produce dentro de la tecnología, funcione como funcione».

El cierre del congreso estuvo a cargo de Javier Candau (CCN-CERT), quien explicó los cambios regulatorios de la Directiva NIS 2 y su impacto en el Esquema Nacional de Seguridad (ENS), resaltando que «la NIS 2 no solo refuerza la protección de infraestructuras críticas, sino que también fomenta una cultura de seguridad proactiva en todos los sectores».

El I Congreso Foro GRC no solo abordó los retos de la ciberseguridad y la privacidad, sino que también puso en relieve el papel esencial de los profesionales de GRC en un entorno de transformación constante. Quedó claro que el profesional de GRC del futuro debe ser un perfil versátil y multidisciplinar, capaz de combinar conocimientos técnicos con una sólida comprensión de la regulación y los principios éticos.

El I Congreso Foro GRC no solo abordó los retos de la ciberseguridad y la privacidad, sino que también puso en relieve el papel esencial de los profesionales de GRC en un entorno de transformación constante. Quedó claro que el profesional de GRC del futuro debe ser un perfil versátil y multidisciplinar, capaz de combinar conocimientos técnicos con una sólida comprensión de la regulación y los principios éticos.

La creciente complejidad de los marcos normativos, sumada al avance acelerado de tecnologías emergentes como la inteligencia artificial, exige una actualización continua y una estrecha colaboración con equipos de distintas áreas para anticiparse a los riesgos y gestionarlos de una manera eficaz.

El congreso dejó una conclusión clara: el futuro del GRC requiere profesionales con una visión estratégica, capaces de afrontar los nuevos desafíos con un enfoque integral. Con este propósito, este nuevo Foro GRC se consolida como un punto de referencia que seguirá impulsando el conocimiento, la innovación y la cooperación entre expertos y profesionales del sector.

David Bascoy

Govertis, parte de Telefónica Tech

En un mundo cada vez más digitalizado, la protección de datos personales se ha convertido en un desafío para empresas y organizaciones. La seudonimización se presenta como una de las técnicas más eficaces para minimizar riesgos y garantizar el cumplimiento del Reglamento General de Protección de Datos (RGPD).

El Comité Europeo de Protección de Datos (CEPD, por sus siglas en inglés) ha publicado las Directrices 1/2025 sobre seudonimización, proporcionando un marco de referencia para su correcta aplicación. En este artículo, analizaremos qué es la seudonimización, sus beneficios y las medidas técnicas necesarias para su implementación adecuada.

1. ¿Qué es la seudonimización y en qué se diferencia de la anonimización?

La seudonimización es definida por el artículo 4.5) como «el tratamiento de datos personales de manera tal que ya no puedan atribuirse a un interesado sin utilizar información adicional, siempre que dicha información adicional figure por separado y esté sujeta a medidas técnicas y organizativas destinadas a garantizar que los datos personales no se atribuyan a una persona física identificada o identificable».

Es importante no confundir la seudonimización con la anonimización:

| Seudonimización | Anonimización |

| Permite la reidentificación si se usa información adicional. | La reidentificación es prácticamente imposible. |

| Los datos siguen considerándose personales bajo el RGPD. | Los datos dejan de ser personales y quedan fuera del RGPD. |

| Se usa en análisis de datos que requieren identificación controlada. | Se usa cuando no es necesario conservar ningún vínculo con los interesados. |

2. ¿Por qué es importante la seudonimización?

Las Directrices 1/2025 del CEPD destacan varios beneficios clave de la seudonimización:

| Reducción de riesgos |

|

| Cumplimiento normativo |

|

| Análisis de datos seudonimizados |

|

| Seguridad en transferencias internacionales |

|

| Seguridad en transferencias internacionales |

|

3. Medidas técnicas y salvaguardas para una seudonimización efectiva

Para garantizar una seudonimización adecuada, el CEPD recomienda aplicar medidas técnicas y organizativas que pueden agruparse en tres grandes bloques:

– En la transformación seudonomizadora:

La seudonimización es un proceso que sustituye o elimina identificadores directos, impidiendo la vinculación con los datos originales sin información adicional protegida. Este proceso se basa en «pseudonymisation secrets» (secretos de la seudonimización), que deben almacenarse por separado y estar protegidos con medidas técnicas y organizativas estrictas para evitar accesos no autorizados.

Existen dos enfoques principales para llevar a cabo la transformación seudonimizadora:

Para una implementación efectiva, los responsables del tratamiento deben evaluar qué atributos modificar, eliminando o sustituyendo identificadores directos y gestionando cuasi-identificadores según el riesgo de reidentificación.

En la fase de recolección de datos, la seudonimización puede aplicarse a través de dos estrategias:

– Para prevenir la reidentificación indebida:

El CEPD enumera varias medidas que pueden aplicarse para reforzar la seguridad y evitar la reidentificación indebida de los datos. Las medidas técnicas se centran en la protección de la infraestructura y los procesos de transformación de los datos, mientras que las medidas organizativas garantizan que el personal involucrado en la gestión de los datos seudonimizados cuente con la capacitación y los controles adecuados. La siguiente tabla resume estas medidas:

| Medidas técnicas |

|

| Medidas organizativas |

|

– En la vinculación de datos seudonimizados

En determinados escenarios, varios responsables del tratamiento pueden necesitar vincular conjuntos de datos seudonimizados dentro de un nuevo dominio de seudonimización. Para ello, se pueden emplear tres estrategias principales:

| Estrategia | Ventajas | Riesgos o desafíos |

| Intercambio de secretos de seudonimización | Permite generar pseudónimos coherentes en todas las partes. | Aumenta el riesgo de accesos no autorizados y filtraciones. |

| Uso de un proveedor de confianza | Garantiza que cada responsable solo pueda reidentificar sus propios datos. | Depende de la seguridad del proveedor. |

| Seudonimización en dos niveles | Refuerza la seguridad al almacenar los secretos en entidades separadas. | Mayor complejidad operativa. |

Independientemente del método elegido, los responsables del tratamiento deben garantizar que los pseudónimos generados no permitan la atribución directa a los interesados sin información adicional protegida.

4. Aplicaciones prácticas de la seudonimización

El Anexo de las Directrices 1/2025 del CEPD presenta varios casos en los que la seudonimización protege la privacidad y garantiza el cumplimiento del RGPD. A continuación, se destacan algunos ejemplos:

| CASO | SOLUCIÓN | IMPACTO |

| Minimización de datos en análisis internos Un sistema de asesoramiento médico digital gestiona datos clínicos de pacientes, pero el equipo de soporte técnico no debe acceder a información sensible. |

Seudonimización de los datos clínicos antes de su gestión, manteniendo separada la información adicional necesaria para la identificación. | Reduce el riesgo de acceso indebido, permitiendo que solo los profesionales autorizados accedan a los datos completos. |

| Protección en ciberseguridad Empresas necesitan compartir información sobre incidentes de ciberseguridad sin revelar detalles personales de clientes o empleados. |

Seudonimización de los reportes antes de su intercambio con otras entidades. | Permite compartir información crítica sin exponer datos personales. |

| Transferencias internacionales seguras Una empresa transfiere datos personales fuera de la UE a un país sin un nivel de protección adecuado. |

Seudonimización previa a la transferencia, garantizando que los datos solo puedan ser vinculados con información adicional protegida. | Reduce los riesgos asociados a accesos no autorizados en jurisdicciones con menor protección de datos. |

| Uso secundario de datos en investigación Datos de pacientes deben utilizarse para investigación estadística sin riesgo de reidentificación. |

Seudonimización estructurada, eliminando identificadores directos y aplicando técnicas como la generalización o aleatorización de cuasi-identificadores. | Permite el análisis de datos sin comprometer la identidad de los sujetos de estudio. |

| Justificación de un tratamiento posterior Un comercio electrónico analiza patrones de compra sin afectar la privacidad de los clientes. |

Seudonimización de los datos de compra, asegurando que no puedan vincularse directamente a clientes específicos. | Permite la toma de decisiones comerciales basada en datos sin violar el RGPD. |

| Acceso a datos seudonimizados por los interesados Un proveedor de identidad debe permitir a los clientes acceder a ciertos datos personales sin exponer su identidad legal. |

Uso de pseudónimos gestionados por la entidad para permitir el acceso seguro a la información relevante. | Mejora la seguridad y la privacidad en la gestión de identidades digitales. |

Estos casos demuestran cómo la seudonimización es una herramienta clave para garantizar el equilibrio entre la protección de datos y la utilidad de la información en distintos sectores.

Las Directrices 1/2025 del CEPD se encuentran actualmente en fase de consulta pública hasta el 28 de febrero de 2025. Se espera que, tras este proceso, se adopten recomendaciones finales que refuercen su aplicación en la UE.

Para más información, puedes consultar el documento oficial aquí: Guidelines 01/2025 on Pseudonymisation | European Data Protection Board

Lluis Sabaté

Govertis, parte de Telefónica Tech

En el mundo digital actual, el concepto de privacidad es más importante que nunca. Una de las herramientas más conocidas para navegar por internet de forma «privada» es el modo incógnito. El modo incógnito es una característica que ofrecen la mayoría de los navegadores web modernos como Google Chrome, Mozilla Firefox, Microsoft Edge y Safari. Aunque muchas personas lo asocian con anonimato absoluto, la realidad es que no es tan «incógnito» como podría parecer. A continuación, exploraremos qué hace realmente este modo, sus ventajas, riesgos y hasta qué punto protege tus datos personales.

¿Qué es el modo incógnito y cómo funciona?

El modo incógnito, también conocido como «navegación privada» permite navegar por Internet sin que el navegador guarde ciertas informaciones en el dispositivo. Cuando usas este modo:

Ventajas del modo incógnito

Sin embargo, hay un malentendido común: este modo no impide que terceros rastreen tu actividad online.

Riesgos y limitaciones del modo incógnito

Pero entonces… ¿Es realmente «incógnito»?

Pero entonces… ¿Es realmente «incógnito»?

La respuesta corta es: no totalmente. Aunque el navegador no almacena ciertos datos en tu dispositivo, es importante entender que no garantiza anonimato total en internet, tu actividad sigue siendo rastreable por:

Consejos para mejorar tu privacidad

Como conclusión podemos decir que «el modo incógnito» es una herramienta útil para proteger tu privacidad en el dispositivo local, pero no es una solución completa para navegar de forma totalmente anónima o segura. Para una protección más robusta de tus datos, es necesario combinarlo con otras herramientas y buenas prácticas de seguridad digital.

Recordemos que, en el mundo digital, la verdadera privacidad requiere más que solo activar un «modo incógnito».

Carolina Pena

Govertis, parte de Telefónica Tech

En los últimos años, la Inteligencia Artificial (IA) ha supuesto una transformación sin precedentes en los procesos de selección de muchas empresas. La implementación de los modelos de IA está revolucionando la manera de trabajar, facilitando la mejora en la eficiencia y en la productividad en los procesos de negocio.

Su función principal en la selección de candidatos es automatizar tareas repetitivas y monótonas, permitiendo al personal de recursos humanos centrarse en los aspectos clave de los procesos.

Ventajas de su uso

Entre sus múltiples ventajas, resaltan las siguientes:

En definitiva, el uso de estas herramientas se traduce en una optimización del proceso, beneficiando tanto el empleador como a los postulantes.

Analizadas sus ventajas, parece como si no hubiera sombras en la utilización de este tipo de herramientas para la evaluación de candidatos. Sin embargo, no es oro todo lo que reluce. ¿Es la IA un arma de doble filo para la selección de candidatos?

Impacto en la privacidad

Al ser una herramienta configurada para simular el comportamiento humano, puede dar lugar a que en la criba de candidatos se tengan en cuenta factores que van más allá de lo objetivo. Por ejemplo, la exclusión en base a su género o etnia o incluso el filtrado de los mismos teniendo en cuenta datos personales de categoría especial, como su orientación sexual.

Cuando los modelos de IA se entrenan, pueden ir adquiriendo progresivamente sesgos vigentes en la sociedad actual, a pesar de que sean sistemas diseñados para operar en el marco de límites éticos.

A modo de ejemplo, si el algoritmo aprende que el 90% de los directivos de empresas son hombres o que el 80% de los puestos de secretaría son mujeres jóvenes, es complicado que, a la hora de realizar la criba no reproduzca el patrón, favoreciendo dichas candidaturas frente a otras que se salgan del mismo para cubrir la vacante.

Un caso notorio fue el de un sistema desarrollado por Amazon que, según el MIT Technology Review (2022), discriminaba contra las mujeres debido a un sesgo en los datos históricos utilizados para entrenarlo.

Son múltiples organismos los que han analizado diferentes modelos de IA y denunciado estas evidencias, entre ellos, la Information Comissioner’s Office (ICO). Tras la realización de auditorías a varios modelos de IA, detectaron la existencia de herramientas que permitían la búsqueda y filtrado de candidatos en base a datos de categoría especial o la solicitud excesiva de datos que, posteriormente, se extraía y combinaba con otros encontrados en sus perfiles de redes sociales o plataformas de empleo.

Por ello, la ICO ha emitido una serie de recomendaciones a desarrolladores y proveedores de soluciones de IA para la selección de personal. Entre los puntos clave del estudio, destacan los siguientes:

En conclusión, el uso de la IA en los procesos de contratación es prometedor. Sin embargo, queda un largo camino para que la tecnología encuentre un equilibrio entre el desarrollo tecnológico y la protección de los derechos y libertades de las personas.

Isabel Abad Ayala

Govertis, parte de Telefónica Tech

El pasado 23 de septiembre tuvo lugar el III Insight del Club del DPD de 2024 organizado por la Asociación Española para la Calidad, con la colaboración de Govertis, parte de Telefónica Tech.

El evento, dirigido por Javier Villegas, Lead Advisor y responsable de Desarrollo de Negocio de Govertis, se dividió en tres partes: una mesa redonda sobre «¿Cómo acreditar el cumplimiento de medidas de seguridad en encargados de tratamiento y la responsabilidad in vigilando?», otra mesa redonda sobre «Gestión de riesgos en proveedores/cadena de suministro y brechas de seguridad» y, un taller práctico sobre cómo llevar a cabo correctamente las Transfer Impact Assessments (TIAs) o evaluaciones de impacto de transferencias internacionales de datos personales.

1. ¿Cómo acreditar el cumplimiento de medidas de seguridad en encargados de tratamiento y la responsabilidad in vigilando?

La primera mesa redonda fue impartida por Eduard Blasi Casagran, abogado especializado en Derecho Digital y Privacidad, y Elena Gil González, abogada especializada en Protección de Datos y Derecho Digital. Se abordó la responsabilidad in vigilando y medidas de seguridad de los encargados de tratamiento.

En primer lugar, Eduard consideró esencial que los responsables de los datos generen una lista de proveedores ya que nos va a permitir tener un termómetro del estado de los terceros en materia de privacidad. Además, de tener otras herramientas como los sellos de confianza y las certificaciones, como la de calidad.

Igualmente, es importante prestar atención a la tipología de los proveedores porque solo aquellos que presentan una especial sensibilidad en el tratamiento de los datos tienen que estar más presentes en nuestro análisis.

Además, hay que tener en cuenta los contratos de encargados de tratamiento para verificar la responsabilidad in vigilando, por eso se debe realizar un triaje de valoración de terceros en el que se incorpore no solo las medidas de seguridad sino también el cumplimiento de la protección de datos, así como una cláusula de auditoría para los terceros proveedores.

Asimismo, Eduard resaltó la verificación del flujo de los datos en las transferencias internacionales de datos y que la labor de control de los proveedores conlleva la atención de derechos, el control de los subencargados, los límites de la responsabilidad y la devolución o destrucción de la documentación una vez finalizada la relación contractual.

Por último, durante su ponencia, Eduard resaltó que la imposibilidad de negociar un contrato de encargado con las grandes multinacionales no supone una eximente o atenuación de responsabilidad ante la Agencia Española de Protección de Datos, aspecto que deberá tenerse en cuenta.

También es necesaria una intervención del DPD para cambios menores en la negociación de los contratos de encargados por el departamento legal de las empresas. Y, terminó apuntando que la accountability consiste en verificar el cumplimiento de las medidas de seguridad en detalle y no rellenar un simple formulario.

A continuación, Elena Gil González, nos habló de la complejidad de abarcar toda la normativa digital recientemente legislada en la Unión Europea; destacando, por su importancia, el Reglamento DORA para entidades financieras, NIST2 para operadores críticos o la normativa de Inteligencia artificial, que regula no solo los aspectos de los datos personales sino también todo lo referente a la tecnología. Lo complicado es aplicar las obligaciones de transparencia sobre la lógica de un modelo algorítmico en una empresa.

Elena incidió en el cuidado con la elección del proveedor y que cualquier error en el modelo de inteligencia artificial va a afectar dicha elección. Así como la excesiva maraña contractual, dado que es muy complicado gestionar por el responsable como también elegir un único proveedor, ya que te hace super dependiente del mismo.

Según Gil, una buena praxis es realizar auditorías anuales y si ocurriese algo, por ejemplo, contar con una sospecha fundada de incidencia de cambio normativo, realizar una auditoría extraordinaria. Además, es importante realizar una distribución de la responsabilidad de los terceros en función de las culpas por la importancia de datos que tratan. Igualmente hay que resaltar que la medición de los contratos de encargados de tratamientos en cuanto a eficiencia requiere mucho esfuerzo y recursos para las empresas, así como el control de los subencargados, ya que hay numerosos.

Por último, apuntó que se requieren elementos de homologación de los proveedores para verificar que cumplen con la normativa, pero que la certificación que se obtenga esté vinculada al problema en cuestión para poder eximir de responsabilidad a la empresa como encargado de tratamiento.

2. Gestión de riesgos en proveedores/cadena de suministro y brechas de seguridad.

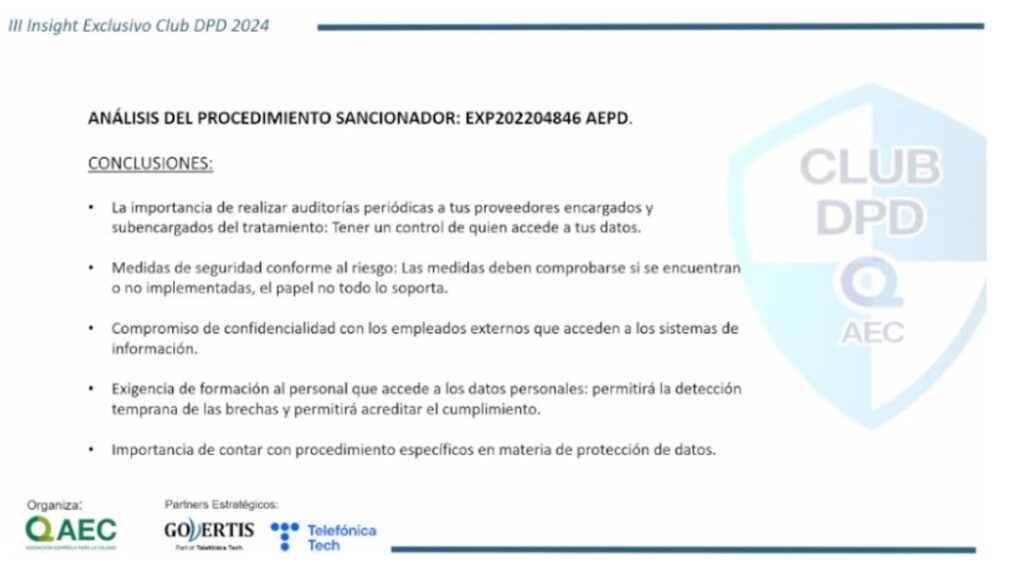

Posteriormente, Javier Cao Avellaneda, Senior Consultant de Govertis y Marcos Rubiales Olmedo, también consultor senior de Govertis, abordaron la gestión de riesgos en proveedores y cadena de suministro, y analizaron un supuesto de una brecha de seguridad que conllevó la apertura de expediente sancionador por la AEPD.

Javier nos indicó que en el programa de gestión de proveedores tenemos que revisar la norma ISO 27001 y NIST SP-800-161, teniendo en cuenta las fases de evaluar, monitorizar y responder, así como los nuevos controles de la ISO 27001 del 5.19 al 5.23.

Por lo tanto, en la fase in eligiendo vamos a desarrollar la clasificación de los proveedores, disponiendo de un inventario inicial y aplicando una proporcionalidad en la criticidad de los mismos orientada al riesgo.

Por ejemplo, se pueden tener criterios de valoración técnicos, es decir, por la tipología del sector, por el grado de confidencialidad, integridad y disponibilidad (la matriz de KRALJIC) incluso la complejidad del servicio, el riesgo inherente al proveedor, la dependencia y ubicación geográfica.

Deja claro que la intensidad del cumplimiento de los requisitos y garantías debe ser proporcional a la importancia y riesgos del proveedor. Y que incluir las garantías previas en esta fase resulta importante, así como establecer una clasificación de proveedores sin impacto, proveedores normales, proveedores esenciales y proveedores críticos. Establecer desde un contrato general a contratos más específicos con SLA, certificaciones, auditorías de terceras partes, scoring tecnológico y agencia rating para aquellos proveedores más importantes.

En la fase in eligendo + in vigilando se va a tener en cuenta los alcances de la certificación otorgada con las certificaciones en seguridad (ISO 27001, 27701 o 22301) y los resultados de la gestión (indicadores de seguridad, evaluación del mantenimiento tras la auditoría) así como otros elementos ya indicados como la auditoria de tercera parte y de dependencias del proveedor.

Por último, en la fase de respuesta los elementos importantes son: identificar al CISO del proveedor con quien hay que hablar del incidente, definir qué incidentes sufre el proveedor que tiene que estar informado al responsable en todo momento, establecer claramente los criterios de gravedad y escalado. Así como la capacidad de respuesta y tiempos de resolución, los contratos de SLAs y, en definitiva, la penalización e indemnización.

A continuación, Marcos Rubiales expuso un análisis de un expediente sancionador de una brecha de seguridad, a partir del robo y posterior venta no autorizada de una base de datos del CRM del responsable. Entre las medidas que debiera haber implementado estaría el doble factor de autenticación como medida preventiva, clave para esta circunstancia, ya que se accedía al CRM. La AEPD detalló que si esta medida se hubiera implementado se hubiera evitado la incidencia.

También entre otras medidas, estaría la realización de una auditoría de control de los proveedores, que, al producirse a posteriori, no se llega a evitar la incidencia.

O la importancia de contar con procedimientos específicos en materia de protección de datos.

Ilustración 1 – Principales conclusiones del análisis del procedimiento sancionador

Ilustración 1 – Principales conclusiones del análisis del procedimiento sancionador

3. Transfer Impact Assesment (TIA): Claves prácticas para abordar correctamente las evaluaciones de impacto de transferencias internacionales de datos.

En la parte final de la sesión se realizó un taller por Félix Haro, consultor senior en Govertis, sobre las evaluaciones de impacto de transferencias internacionales de datos personales.

Básicamente, indicó que hay que procurar un nivel equivalente en los países al que marca la UE, el denominado nivel de protección sustancialmente equivalente.

Asimismo, el Considerando 108 del RGPD nos marca cómo conseguir un nivel equivalente y aparte de los instrumentos que pone a disposición el Reglamento, como las cláusulas tipo hay garantías adicionales que no vincula a organismos públicos solo entre las partes.

Al no indicarlo expresamente el RGPD, nos podemos ir a las Recomendaciones 1/2020 CEPD para saber cuáles son las medidas que complementan los instrumentos de transferencia.

El proceso para conocer las transferencias parte del Registro de actividades de tratamiento (RAT), conocer los encargados y subencargados y cumplir con la minimización como principio, aunque los softwares no suelen ser flexibles, y te dan licencia en bloque.

Además, es importante determinar los instrumentos de transferencia con el orden jerárquico:

1. Decisión de adecuación (45).

2. Garantías adecuadas (46).

3. Excepciones.

Además, hay que ver si las cláusulas contractuales tipo se ajustan a uno en función de las circunstancias específicas:

a) Tener en cuenta la legislación de la privacidad.

b) Legislación de vigilancia.

c) Acceso por autoridades públicas.

d) Independencia de las autoridades de Protección de datos.

Incluso hay que evaluar si el instrumento de transferencia es eficaz, con las Recomendaciones 2/2020, analizar la injerencia injustificable con normas claras, precisas, necesidad y proporcionalidad, mecanismos de supervisión independientes, recursos efectivos a disposición del interesado.

En el caso de legislación problemática, podemos suspender la transferencia, aplicar medidas complementarias o no aplicar la legislación problemática.

Un aspecto para verificar la eficacia de nuestro instrumento a utilizar en la transferencia internacional es en base a las fuentes de jurisprudencia, resoluciones e informes de órganos de control.

Una vez que el instrumento de transferencia no es suficiente por las características de la legislación, podemos tomar medidas técnicas en el acceso como el cifrado, en tránsito y local, realizar una transferencia datos seudonimizados, que el receptor esté protegido por legislación local o el tratamiento esté fraccionado.

Es importante tener en cuenta que hay legislaciones en los que hay prohibición de cifrado. Otras medidas como las contractuales entre las que encontramos la utilización de medidas técnicas específicas, la transparencia y responsabilidad proactiva como registro de solicitudes o los métodos de organización y adopción de normas y buenas prácticas.

Incluso hay medidas complementarias como las políticas internas de gobernanza, obligaciones de transparencia (solicitudes de acceso recibidas) o la operativa (puertas traseras software, procesos comerciales, impugnación órdenes) o las auditorías o inspecciones.

Por último, necesitamos realizar una evaluación periódica y un seguimiento, así como cumplir la responsabilidad proactiva.

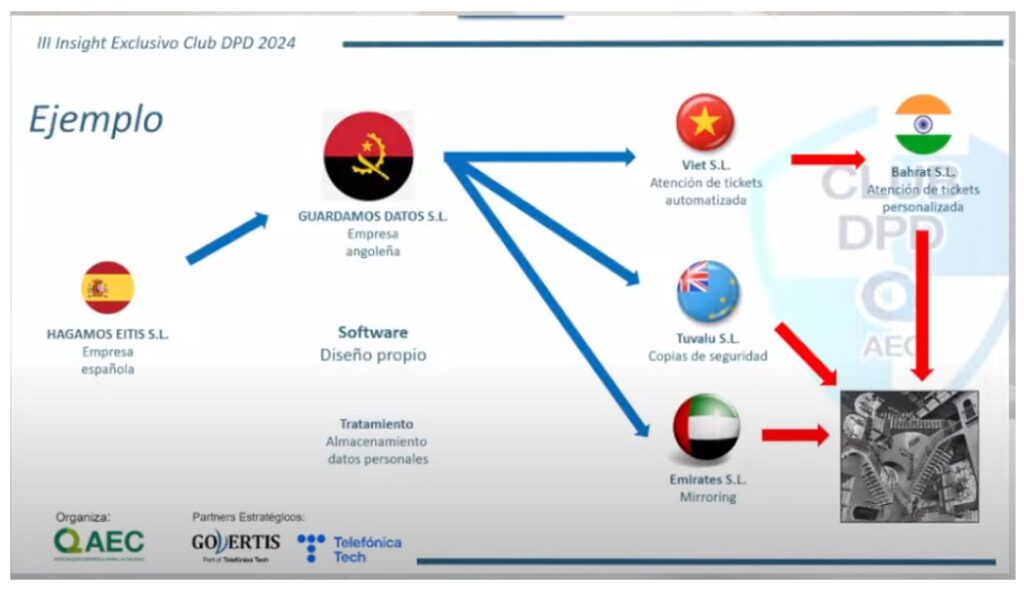

Ilustración 2 – Ejemplo de transferencia internacional de datos

Ilustración 2 – Ejemplo de transferencia internacional de datos

Por último, en las conclusiones finales, resalta la necesidad de realizar una evaluación de riesgos, calcular el riesgo, verificar la amplitud del tratamiento, verificar las actividades de vigilancia gubernamental y, por supuesto, realizar un control más continuo junto con la agilidad, que en definitiva es un sistema de gestión, así nos permitirá efectuar la evaluación más exhaustiva de las transferencias internacionales de datos.

José Alberto Rueda

Govertis, parte de Telefónica Tech

Una vez que tenemos claro a dónde van los datos personales de nuestra responsabilidad, y que son adecuados, pertinentes y limitados a lo necesario en relación con los fines para los que se van a tratar, el segundo paso que tenemos que seguir es la determinación del instrumento en el que vamos a basar la transferencia (Capítulo V RGPD).

Los instrumentos que tenemos a nuestra disposición son los siguientes:

1. Decisiones de adecuación de la Comisión Europea (art. 45 RGPD).

2. Instrumentos de transferencia que ofrecen garantías adecuadas (art. 46 RGPD).

3. Vía de excepción (art. 49 RGPD).

La vía de excepción del artículo 49 permite la transferencia internacional siempre y cuando no dispongamos de una decisión de adecuación de la Comisión Europea, ni podamos hacer la transferencia conforme a algún instrumento que ofrezca las garantías adecuadas. Es decir, a la hora de elegir el instrumento adecuado hemos de comprobar primero si existe una decisión de adecuación; después, si podemos realizarla conforme a cualquier instrumento de transferencia con garantías adecuadas, y solo en ausencia de las dos primeras opciones, acudir a la vía de excepción.

Como cierre, si tampoco fuera aplicable ninguna de las excepciones que ofrece el artículo 49 RGPD, solo podremos llevar a cabo la transferencia internacional si no es repetitiva, afecta solo a un número limitado de interesados, es necesaria a los fines de intereses legítimos imperiosos que persigamos y sobre los que no prevalezcan los intereses o derechos y libertades del interesado, y hayamos evaluado todas las circunstancias concurrentes en la transferencia de datos. Basándonos en esta evaluación, habremos de ofrecer garantías apropiadas con respecto a la protección de datos personales, y en este caso, habremos de informar a la autoridad de control de la transferencia.

1. Decisiones de adecuación.

La Comisión Europea ha reconocido que ciertos países ofrecen un nivel adecuado de protección de los datos personales. Si la empresa importadora se encuentra en alguno de estos países, no tendremos que adoptar ninguna otra medida adicional.

2. Instrumentos de transferencia con garantías adecuadas.

Los instrumentos numerados en el artículo 46 (cláusulas tipo, normas corporativas vinculantes, códigos de conducta, mecanismos de certificación y cláusulas contractuales específicas) contienen garantías adecuadas y pueden ser utilizados en ausencia de decisión de la Comisión Europea. El instrumento tiene que garantizar que los datos personales transferidos gocen de un nivel de protección esencialmente equivalente, pero hemos de tener en cuenta que es posible que la situación del tercer país al que exportamos los datos personales puede requerir que tomemos medidas complementarias para garantizar ese nivel de protección.

3. Evaluación de la eficacia del instrumento de transferencia.

Es posible que en el país de destino de la transferencia existan legislación o prácticas en vigor que socaven la eficacia de las garantías adecuadas de los instrumentos de transferencia del artículo 46 RGPD. La protección ofrecida ha de ser esencialmente equivalente a la garantizada en el Espacio Económico Europeo, y habremos de comprobar este extremo con la ayuda del importador de los datos personales, y siempre sobre las circunstancias específicas de la transferencia de datos que pretendemos llevar a cabo, nunca de modo general. Es recomendable acordar con el importador los extremos de esta colaboración y fijarlos en un documento de trabajo conjunto, ya que habrá que revisar la evaluación si se producen cambios que puedan afectar a las circunstancias de la transferencia.

Además de las circunstancias específicas de los datos que se quieren transferir (tipo de datos, finalidad, formato de transferencia, entidades participantes, etc.), es muy importante incluir a todos los agentes que puedan participar, sobre todo si van a existir transferencias ulteriores. Habremos de exigir información fiable al importador sobre estas transferencias, así como documentar todas sus características e incluirlas en nuestra evaluación de idoneidad.

Tendremos que comprobar si la legislación vigente y las prácticas en el país respeta los derechos fundamentales de los titulares de los datos personales. Es posible que se concedan poderes a las autoridades públicas que los restrinjan, pero habrá de tratarse de medidas necesarias y proporcionadas en una sociedad democrática, al igual que ocurre en los Estados miembros de la Unión Europea. Se considera que son incompatibles si no respetan la esencia de los derechos y libertades fundamentales de la Carta de los Derechos Fundamentales de la Unión Europea, o si exceden lo dispuesto en las salvaguardas contempladas en el artículo 23 RGPD. Para esto, acudiremos a las Recomendaciones 02/2020 del Comité Europeo de Protección de Datos sobre las garantías esenciales europeas para medidas de vigilancia, de 10 de noviembre de 2020, para conocer qué se entiende como injerencia justificable.

Como resultado final de esta evaluación, es posible que encontremos que la legislación presente problemas de compatibilidad, que no garantice el nivel esencialmente equivalente de protección y que la transferencia de datos personales o la actividad del importador caiga bajo el ámbito de aplicación de esta legislación. En este caso, tendremos tres opciones:

1. No realizar la transferencia o suspenderla, si es que se estaba llevando a cabo.

2. Aplicar medidas complementarias para lograr el nivel de protección.

3. No aplicar medidas complementarias si no hay motivos para creer que esta legislación se aplique al caso concreto.

Como siempre, habremos de documentar exquisitamente este análisis para cumplir con el principio de responsabilidad proactiva.

Félix Haro

Govertis, parte de Telefónica Tech

El pasado 11 de junio tuvo lugar el II Insight del Club del DPD de 2024 organizado por la Asociación Española para la Calidad, con la colaboración de Govertis, parte de Telefónica Tech.

El evento fue dirigido por Javier Villegas, Lead Advisor y responsable de Desarrollo de Negocio del territorio sur de Govertis y se dividió en tres partes: la ponencia sobre «Privacidad y Marketing digital, ¿cómo nos preparamos para un mundo sin cookies?»; la mesa redonda sobre «El papel del DPD en los medios de comunicación. ¿Una profesión de riesgo?» y, un taller práctico sobre el desarrollo de proyectos de investigación y protección de datos.

La primera ponencia fue impartida por Lorena Roque Masi, responsable de Ads Privacy en Google España, en la que se trató de abordar la influencia de las cookies en la vida cotidiana de las personas y en el marketing digital.

«Nos movemos de un mundo donde medíamos el 1:1 a un mundo consentido, agregado y anonimizado. Tenemos que aprender a hacer más con menos» – explicó Roque destacando que los cambios regulatorios y tecnológicos para proteger la privacidad de los usuarios en internet están transformando radicalmente la industria de la publicidad online.

En un segundo bloque, se dio paso a una mesa redonda moderada por Santiago Cruz Roldán, DPD externo en Tele Madrid y miembro de Govertis Telefónica Tech, en la que participaron Luis Javier Sánchez, periodista especializado en Derecho TIC y Jesús Fernández Acevedo, abogado y DPD, la cual versó sobre la problemática del tratamiento de los datos personales en los medios de comunicación. En concreto, durante las ponencias se abordaron las siguientes cuestiones:

1. La ponderación entre el derecho a la libertad de información y el derecho a la protección de datos en situaciones de inmediatez.

Luis Javier Sánchez indicó que esta cuestión es una problemática que se lleva arrastrando desde hace mucho tiempo y para la que no existe una solución concreta. Los medios de comunicación han ido aprendiendo lo que se puede o no se puede publicar a raíz, por ejemplo, de sanciones impuestas por la Agencia Española de Protección de Datos (AEPD).

Actualmente, se tiene un especial cuidado con temas relacionados con menores o anonimización de sentencias jurisprudenciales, sin embargo, sigue siendo un ámbito escasamente regulado.

2. La necesidad de establecer unas directrices que regulen la protección de datos en los medios de comunicación.

Jesús Fernández puso de relieve la necesidad de concienciar a los periodistas sobre la normativa de protección de datos y cómo esta puede afectar a la calidad de las noticias. En este sentido, Jesús defendió la importancia de contar con un protocolo que regule esta materia como ocurrió con el documento de «buenas prácticas en materia de comunicación» elaboradas por la Autoridad Italiana de Protección de Datos que contiene una serie de recomendaciones sobre cómo se puede tratar la información de una forma ética y respetuosa.

Ambos ponentes apuntaron la pérdida de oportunidad del Legislador español de regular esta materia a raíz de la entrada en vigor del actual Reglamento General de Protección de Datos (RGPD).

3. La importancia de la figura del DPD en los medios de comunicación.

Respecto a este tema, Jesús Fernández quiso resaltar que la figura del DPD en los medios de comunicación no está suficientemente valorada, en numerosas ocasiones, debido a la inmediatez que requieren determinadas noticias.

Por ello, según Fernández, es fundamental formar a los trabajadores de los medios de que existe la figura y las funciones del DPD para que puedan acudir a ellos en los casos de duda.

A raíz de lo expuesto durante la jornada, Luis Javier Sánchez abogó por la creación de un Pacto Digital entre los medios de comunicación y la Agencia Española de Protección de Datos.

4. ¿La actuación del DPD en determinadas ocasiones es vista por los periodistas como una injerencia?

En este sentido, Luis Javier Sánchez apuntó que los periodistas, en un primer momento, sí que pueden ver la actuación del DPD como un obstáculo debido a la inmediatez con la que se publican las noticias. Explicó que sería obligatorio un diálogo interno en los medios donde se exponga la necesidad de ser cauteloso en determinadas ocasiones por las posibles consecuencias que pueden surgir posteriormente como, por ejemplo, multas de la AEPD.

Asimismo, según Jesús Fernández, cada vez hay más periodistas concienciados con dar cumplimiento a la normativa de protección de datos.

5. ¿Qué protocolos se puede implementar para dar cumplimiento a la normativa de protección de datos?

Fernández sostuvo que es necesario realizar una evaluación de los contenidos que puedan generar más riesgo (grabaciones de menores durante las cabalgatas del día de Reyes, a las puertas de juzgados y tribunales o de los cofrades durante las procesiones de Semana Santa) y tener un mapa de actuación.

La conclusión general de la ponencia se tradujo en la creación de un protocolo donde se recojan los aspectos clave que deben tener en cuenta los medios de comunicación para dar cumplimiento a la normativa de protección de datos.

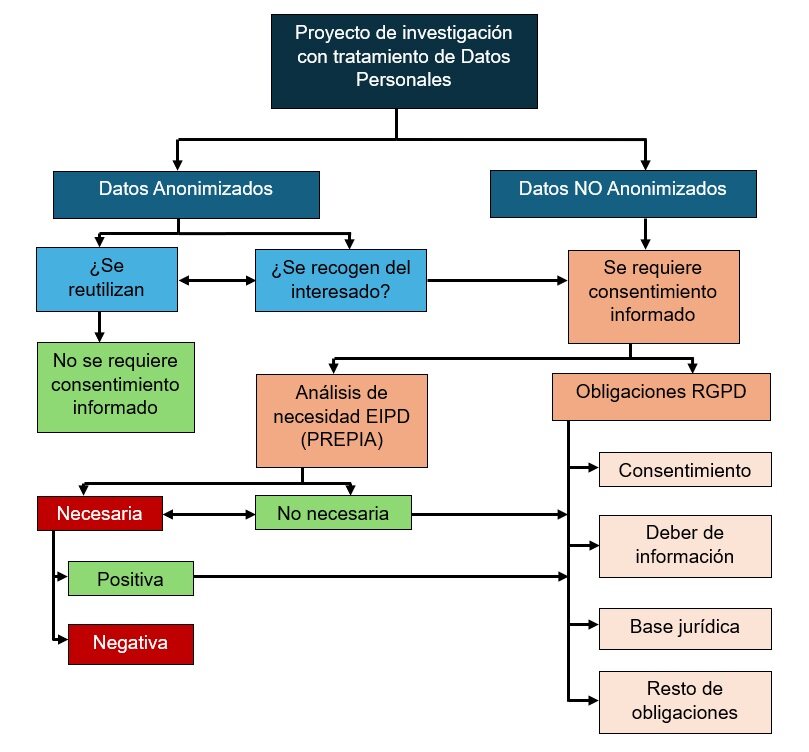

Para finalizar el encuentro, se dio paso a Borja Sendra Buigues, DPD y miembro de Govertis, parte de Telefónica Tech, que impartió un taller práctico orientado a cómo aplicar la normativa sobre protección de datos en los comités de ética universitarios en proyectos de investigación.

Durante la ponencia, se explicó que el papel del DPD en el Comité de ética y evaluación es dar soporte a los investigadores (redacción de cláusulas informativas, realizar una Evaluación de Impacto de la Protección de Datos -EIPD- o instruir sobre el buen uso de la información) y, velar por el cumplimiento de la normativa.

En concreto, los proyectos de investigación es preciso que cumplan el principio de privacidad desde el diseño y por defecto, diseñando el tratamiento en la memoria del proyecto e imponiendo las medidas necesarias para proteger los datos, que se aplicarán durante todo el proceso y cuando este finalice.

El Comité es responsable de analizar toda la información del proyecto (tipología de datos, origen, finalidad, destinatarios, información facilitada a los interesados, etc.) para comprobar si el tratamiento es conforme al RGPD.

En resumen, los pasos que tiene que seguir el Comité para analizar si un proyecto de investigación cumple con las obligaciones recogidas en el RGPD son los siguientes:

II Insight del Club del DPD – 2024

Claudia Arias

Govertis, parte de Telefónica Tech

Las recomendaciones 01/2020

El Comité Europeo de Protección de Datos (CEPD) elaboró las recomendaciones 01/2020 sobre medidas que complementan los instrumentos de transferencia para garantizar el cumplimiento del nivel de protección de los datos personales de la UE, para ayudar a los exportadores de datos personales (responsables o encargados) a evaluar a terceros países y tomar medidas complementarias para mantener un nivel de protección esencialmente equivalente al garantizado en el Espacio Económico Europeo.

Es importante resaltar que estamos ante recomendaciones, lo que implica la posibilidad de adaptar el método que proponen para optimizarlo aún más, mediante la incorporación de más fases o medidas adicionales, siempre y cuando estemos seguros de su efectividad y podamos respaldar su utilidad mediante pruebas sólidas.

El método

El método propuesto por el CEPD tiene como objetivo principal que el exportador sepa si tiene que tomar medidas complementarias para poder transferir los datos y la implementación de estas si procediese. Consta de cinco pasos:

1º. Conocer la transferencia

2º. Determinación del instrumento de transferencia

3º. Evaluación de eficacia del instrumento de transferencia

4º. Adopción de medidas complementarias

5º. Procedimiento de aplicación de medidas complementarias

En la ejecución del método habremos de documentar de un modo exquisito las fuentes en las que nos apoyemos, la colaboración recibida por parte del importador de los datos, las medidas que se ponen en marcha antes de realizar la transferencia y cualquier decisión que se tome junto con los parámetros que han llevado a ella. En mi opinión, es recomendable formar un “expediente” específico para cada transferencia, en el que incluyamos toda la información referente a ella. No podemos perder de vista que la autoridad de control puede solicitar esta documentación, con la que demostraremos que hemos actuado con la diligencia debida a la hora de realizar la transferencia, cumpliendo con el principio de responsabilidad proactiva.

Conocer la transferencia… ¿fácil?

El primer paso en esta evaluación de impacto es conocer la transferencia. Las recomendaciones sugieren partir del registro de actividades de tratamiento, que ha de contener una descripción de la transferencia y de las garantías adecuadas, en su caso. Aquí nos encontramos con el primer reto, porque tal y como apunta el CEPD, “registrar y catalogar todas las transferencias puede ser un ejercicio complejo para las entidades que participan en transferencia múltiples, diversas y periódicas con terceros países y que utilizan una serie de encargados y subencargados”.

La inmensa mayoría de las transferencias internacionales se producen cuando el exportador de datos utiliza los servicios de empresas de soluciones de software. Es altamente probable que estas empresas, en la configuración de los sistemas que ponen a disposición del exportador, dispongan de subencargados que intervienen de una forma u otra en la gestión de la información o en la gestión del mismo software, siendo auxiliares necesarios en esa transferencia.

Vamos a poner un ejemplo sencillo. Imaginemos que el software de la empresa norteamericana HAPPY PEOPLE (obviamente nombre ficticio) sirve para gestionar el nivel de felicidad de los empleados de una empresa situada en España, que la contrata y será la empresa exportadora de datos. Conforme a la información proporcionada por HAPPY PEOPLE, el software hará los análisis de felicidad en los Estados Unidos y los datos personales de los empleados de la empresa española se alojarán y analizarán allí. Sin embargo, las copias de seguridad se llevan a cabo por una empresa india en sus propias instalaciones en Nueva Delhi, y la asistencia técnica en caso de errores de los usuarios o en el mismo software se lleva a cabo en Costa Rica desde un centro de llamadas y de recepción de peticiones de ayuda por correo electrónico. En este caso nos encontramos con que al menos tenemos dos empresas más, la india y la costarricense, como subencargadas, y además, no están situadas en países que tengan reconocido un nivel equivalente de protección de datos al del EEE.

Pero la historia puede no terminar aquí, ¿qué ocurre si a su vez, esas empresas subencargadas, para prestar sus propios servicios recurren a otras empresas también de software no situadas en países con equivalente nivel de protección al del EEE? Pues sí, exactamente eso: que nos encontramos con que todas las transferencias ulteriores que se realicen han de estar sujetas al mismo régimen de protección equivalente, y consecuentemente, habremos de evaluar el impacto de la transferencia teniéndolas en cuenta.

En este primer paso, las recomendaciones también nos recuerdan el principio de la minimización de los datos. La transferencia deberá restringirse únicamente a los datos adecuados, pertinentes y limitados en relación con las finalidades para las que serán tratados. Recordemos los flujos de datos personales necesarios para usar el software de HAPPY PEOPLE: unos datos personales son los que son enviados desde la empresa exportadora española a Estados Unidos para análisis de felicidad, y otros son los que deberían ser transferidos por ésta posteriormente para las copias de seguridad que se hacen en India, o los que se han de enviar para la asistencia técnica telefónica o por correo electrónico desde Costa Rica… ¿Qué datos específicos van a cada empresa y para qué?

Sirva el ejemplo para ilustrar la posible complejidad del primer paso que, a pesar de parecer inocente, esconde bastantes dificultades.

Félix Haro, CIPM, CIPP/e, CIPP/us

Govertis part of Telefónica Tech

¿Pero cómo empezó todo esto?

La sentencia Schrems II anuló el Escudo de Privacidad como posibilidad para realizar transferencias internacionales de datos personales a EE.UU. debido a la legislación que permite acceder a datos personales transferidos desde la UE con fines de seguridad nacional. La Sección 702 de la Ley de Vigilancia de Inteligencia Extranjera (FISA, Foreign Intelligence Surveillance Act) permite llevar a cabo investigaciones de vigilancia de personas extranjeras ubicadas fuera de EE.UU. con la ayuda de los proveedoresde servicios de comunicación, y la Orden Ejecutiva 12333 habilita a la Agencia de Seguridad Nacional para obtener datos en tránsito antes de que lleguen a Estados Unidos.

La Comisión Europea adoptó, tras una ardua negociación con EE.UU., la decisión de adecuación el 10 de julio de 2023, el Marco de Privacidad de Datos UE-EE.UU., que pone a las empresas norteamericanas que se adhieran al Marco de Privacidad en igualdad de condiciones con las que se encuentren en países que tienen reconocido un nivel de protección adecuado por la Comisión. En ambos casos no resultará necesario acudir a ninguno de los instrumentos contemplados en punto 2 del artículo 46 RGPD.

La Decisión de la Comisión Europea 2021/914 puso a disposición de las organizaciones el nuevo conjunto de cláusulas contractuales tipo, que abordaron ciertas deficiencias de las cláusulas anteriores, y abordan transferencias de datos que involucran a múltiples partes, respondiendo también a la sentencia Schrems II.

En lo básico, la situación es parecida a la anterior: las organizaciones disponen de las decisiones de adecuación en el caso de ciertos países, entre los que ya se encuentran los EE.UU., y los instrumentos del artículo 46 RGPD, una vez modificadas las cláusulas contractuales tipo propuestas por la Comisión Europea.

Cómo llegamos a la necesidad de evaluar el impacto de las transferencias internacionales

La sentencia Schrems II no solo anuló el Escudo de Privacidad, sino que también cuestionó el uso de las cláusulas contractuales tipo, ya que solo son obligatorias para las partes firmantes, pero no para el país tercero en el que se encuentra la organización que importa los datos personales procedentes del Espacio Económico Europeo. En este caso, la legislación de ese país tercero puede permitir a sus autoridades públicas acceder a esos datos personales y llevar a cabo injerencias en los derechos de los interesados relativos a esos datos. No ocurre lo mismo en el caso de las transferencias a los países cuyo nivel de protección ha sido declarado equivalente por la Comisión, porque este tipo de decisiones sí que se adopta solo si se ha constatado que la legislación del país tercero sí que tiene todas las garantías exigibles, como establece el artículo 45 RGPD en su punto 3.

Vemos entonces que en el caso de las cláusulas contractuales tipo anteriores, al no examinarse en particular la legislación del país de destino, el responsable o el encargado debían ofrecer las garantías adecuadas, y conforme a los considerandos 108 y 114, “deben tomar medidas para compensar la falta de protección de datos en un tercer país mediante garantías adecuadas para el interesado” y que “esas garantías deben asegurar la observancia de requisitos de protección de datos y derechos de los interesados adecuados al tratamiento dentro de la Unión, incluida la disponibilidad por parte de los interesados de derechos exigibles y de acciones legales efectivas (…) en la Unión o en un tercer país”.

El responsable o el encargado deben entonces proporcionar medidas adicionales para garantizar el respeto del nivel de protección exigido por el Derecho de la Unión Europea.

Para solucionar esta situación, el 10 de noviembre de 2020 el Comité Europeo de Protección de Datos (CEPD) publicó y sometió a consulta púbica las Recomendaciones 01/2020 sobre medidas que complementan los instrumentos de transferencia para garantizar el cumplimiento de nivel de protección de los datos personales de la UE. Transcurrido el plazo de consulta, el 18 de junio se publicaron las definitivas, disponibles en el sitio web del SEPD.

Así que tenemos que las organizaciones se enfrentan al reto de tener que evaluar caso por caso las transferencias internacionales que realizan para comprobar el nivel de protección de datos en los países de destino. Esto es lo que se conoce como una evaluación de impacto de transferencias internacionales (EITI), evaluación que ha de contemplar diferentes aspectos, como veremos en la segunda parte.

Félix Haro, CIPM, CIPP/e, CIPP/us

CdC Internacional part of Telefonica Tech.

En el presente artículo expondremos las nuevas actualizaciones en materia de cookies, las cuales revisten de una especial importancia, ya que reflejan la continua evolución de las regulaciones y prácticas relacionadas con el tratamiento de cookies en el entorno digital.

En primer lugar, destacamos la actualización de la Guía sobre el uso de las cookies del pasado mes de julio, cuya finalidad era adaptarla a las Directrices 03/2022 sobre patrones engañosos del Comité Europeo de Protección de Datos (CEPD).

Si bien el objetivo principal de las Directrices era la regulación de las interfaces de las redes sociales, también se afirma que los patrones de diseño engañosos no son exclusivos de tales plataformas, pudiendo incluir sitios web, tiendas en línea, videojuegos, aplicaciones móviles…

No obstante, con la incorporación de tales Directrices a la Guía de cookies, estas exigencias se vieron ampliadas a todos aquellos prestadores de servicio de la sociedad de la información, quienes tuvieron que cumplirlas estableciéndose, como plazo para ello, el pasado 11 de enero de 2024.

Por lo tanto, los prestadores de servicios de la sociedad de la información tendrán la obligación de evitar los patrones engañosos cuando informen acerca del uso de cookies a sus usuarios, en concreto, en lo relativo a las acciones de aceptar o rechazar las cookies. Los patrones que deberán evitar, según lo señalado en las Directrices, serán: la sobrecarga de opciones, omisión de información, señales visuales contradictorias, bloqueo de gestión de datos, así como los diseños inconsistentes, poco claros y oscuros.

Cabe destacar que el principio de licitud del tratamiento (artículo 5 RGPD) es el punto de partida para evaluar la presencia de patrones de diseño engañosos.

En la siguiente imagen que recoge el CEPD en las Directrices, se detallan las categorías de patrones de diseño engañosos y sus subcategorías. De igual modo, se enumeran las disposiciones del RGPD más afectadas por estos tipos de patrones, incluyendo también ejemplos y casos de uso (UC) correspondientes para ayudar a encontrar los diferentes patrones de manera más ágil.

Por otro lado, no debemos olvidar los requisitos de transparencia de la información relativo al uso de cookies, que exigen que la información facilitada en dicha política sea concisa, transparente e inteligible. Además, se deberá utilizar un lenguaje claro y sencillo, evitando frases o palabras que pudieran inducir a error al usuario. Asimismo, la información deberá resultar de fácil acceso y evidente para el usuario en todo momento, tanto a la hora de prestar el consentimiento, como una vez prestado.

Estos requisitos de transparencia serán exigibles tanto en la información facilitada al usuario en las capas 1 y 2, tal y como detallábamos en el anterior artículo “Cookies en el horno: última llamada para su cumplimiento”, del Blog de la Asociación Española para la Calidad (AEC).

Respecto a la información facilitada en la primera capa, la Guía de la AEPD exige que las acciones de aceptar o rechazar cookies se presenten en un lugar y formato destacados, debiendo encontrarse tales acciones en el mismo nivel, sin que resulte más complicado rechazarlas que aceptarlas. Además, se incluyen nuevos ejemplos sobre cómo deben mostrarse estas opciones, ofreciendo indicaciones relativas al color, tamaño y lugar en el que aparecen, entre otros. A modo de ejemplo, el CEPD indica que un tamaño pequeño o un color que no contraste lo suficiente como para ofrecer una clara legibilidad pudiera tener un impacto negativo y resultar engañoso para los usuarios, al igual que modificar los colores de los interruptores de consentimiento.

Otro punto importante de la Guía es la relativa a los llamados “muros de cookies”. Con la nueva actualización se permite que la alternativa a la no aceptación de cookies a la hora de navegación en un sitio web, pueda ser de pago, lo que se traduce en que el usuario puede verse obligado a pagar un precio por acceder a dicha información si no desea la implementación de determinadas cookies que no se encuentran exentas de consentimiento, como las cookies de análisis o medición o de publicidad comportamental. Como se ha podido observar con mayor frecuencia en las últimas semanas, ya son muchas las webs que incluyen el llamado “Pay or OK”, teniendo el usuario, por lo tanto, la opción de aceptar seguir navegando de manera gratuita, a cambio de la instalación de cookies no exentas de consentimiento en su dispositivo, o bien pagar una cuota, lo que le permitirá seguir navegando sin publicidad y, por tanto, sin la instalación de cookies no exentas en sus dispositivos.

El pasado mes de noviembre, la organización austriaca sin ánimo de lucro NOYB (Centro Europeo de Derechos Digitales) planteó una reclamación contra el “Pay or OK” instaurado por META, al ascender la cantidad solicitada por la entidad a cada usuario a un total de 251’88€ al año por “conservar su derecho fundamental a la protección de datos en Instagram y Facebook», tal y como señala la propia organización en su nota de prensa. La organización considera que dicho consentimiento no se trataría de un consentimiento libre, además de ser accesible solamente para personas pudientes económicamente. Quedaremos a la espera de la resolución de la autoridad austriaca de protección de datos al respecto.

Por último, en este mes de enero, la AEPD ha publicado una nueva guía sobre el uso de cookies para herramientas de medición de audiencia. Dicha información se ha incorporado mediante la creación de un Anexo II, lo que implica una nueva actualización de la Guía sobre el uso de cookies.

En esta guía se aborda el uso de herramientas de medición de audiencia y cookies en la gestión de sitios web o aplicaciones móviles por parte de los editores, cuestión esencial para recopilar estadísticas de tráfico o rendimiento necesarias para la prestación del servicio. Asimismo, la guía detalla las condiciones que permiten que determinadas cookies de medición puedan estar exentas de requerir consentimiento, siempre que su propósito sea limitado a la medición exclusiva de la audiencia y se utilicen para producir datos estadísticos anónimos.

A tal efecto, la AEPD considera estrictamente necesario el tratamiento de los siguientes datos, por lo que no será necesario obtener el consentimiento de los usuarios:

De igual modo, se establecen garantías mínimas para el uso de cookies exentas que deben ser implementadas por el editor, como informar a los usuarios del uso de las cookies a través de políticas de privacidad; limitar la vida útil de las cookies, y conservar la información recopilada por un período específico que no debe superar los 25 meses, debiendo realizarse revisiones periódicas.

Cuando se recurre a un proveedor de servicios de medición de audiencia, se exige un compromiso contractual que prohíba la reutilización de datos y que garantice un tratamiento independiente de datos en caso de servir a más editores. También se requiere que el proveedor restrinja el tratamiento de datos a propósitos específicos y a cumplir con las condiciones para la transferencia de datos fuera de la Unión Europea. Finalmente, será necesaria una evaluación para asegurar que las herramientas del proveedor cumplen con los requisitos establecidos.

En resumen, resulta evidente que el “mundo cookie” ha experimentado numerosas modificaciones en los últimos meses. No obstante, aún estamos a la espera de conocer las acciones que tomarán las autoridades de control, así como la respuesta de los usuarios frente a tales cambios significativos.

Cristina Zato, CdC Privacidad de Govertis part of Telefonica Tech